高联丽研究员荣获IEEE Transaction on Multimedia最↑佳论文奖

近日,以电子科☆技大学未来媒体研究中心高联丽研究员为第一作者的论文《Video Captioning with Attention-based LSTM and Semantic Consistency》获得多媒体领域顶级期刊《IEEE Transaction on Multimedia》(IEEE TMM)杂志2020年最◥佳论文奖(2020 Prize Paper Award)。这是电子科技大学首次获得此奖项。该论文作者及作者单位为:高联丽(电子科大)、郭招(电子科大)、张含望(新加坡南●洋理工大学)、徐行(电子科大)、申恒涛(电子科大)。

创刊于1999年的IEEE多媒体汇刊是多媒体领域最具影响力的顶●级期刊,期刊影响因子6.051。IEEE Transaction on Multimedia最佳论文奖是由国际多媒体领域资深专家组⊙成的IEEE TMM评奖委员会,根ξ据论文创新性、实用性、时效性、写作表达等方面,从过去三年发表的所有论文中推荐评选出的唯一最佳论文奖。

高联丽研究员的论文自2017年发表ㄨ以来,得到国内外同行广泛关注,入选ESI高被引论卐文,获Google学术引用241次。

该论文研究主题为视频描述生成(Video Captioning),属于计算机视觉和自然语言处理的交叉领域,目的是通过算法能够总结视频当中发生的一些事情或者记◥录一下人类的某些信息,并生成一些符合人类语言规则的描述。作者发现,当前的大多数方法都是将整个视频的帧或者片段均等得输入到算法模型当中,从而忽略了↘有些视频帧或者片段其实对视频内容起着至关重要的作用,有些帧或者片段对整个视频的影响微乎其微。此外一些方法还因为忽略了句子语义和视觉内容之间的相关性的情况,导致翻译错误,视频内容和生成句子内容不一致的问题。

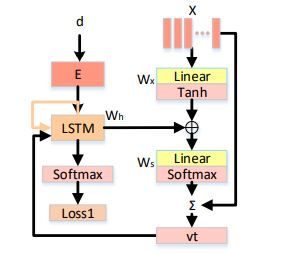

为了解》决这个问题,作者提出了一个基于注意力长短时记忆网络的一致性模型,它能够发掘视频当中显著的一些视频片段来辅助获取更加具有代表←性的视频内容,同时还能构建语言和视觉信息的一致性,使得生成的句子语义和视频当中的语义保持一致。

该工作设计了一种基于注意力机制的长短时记忆单元,如上图所示ζ,在每一次解码生成单词的时候,基于注意力的长短时记忆单元都会根据每一帧图像或者每一个片段视频的重要性赋予其一个权重,最终加权之后的视觉♂特征被作为最终的视觉表征来帮助预测下一个单词。这样的注意力单元能够帮助模型定位具有特征表示能力的片段,更加准确的挖掘到重要的视频内容信息。

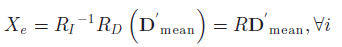

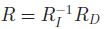

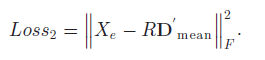

为了保证生成句子和视频内容的一致性,除了现有的从视频转化为句子的损失函数』之外,该工作又引入了一个视觉和语言的一致性损失函数,以保证两者表达的语义保持一致,不会〓出现语义上的偏差,同时创建了一个两种模态数据交叉关联的映射函数,将语言和视觉两种模态的数据通过线性变换映射到一个高维语义空间:

为了构建两种模态之间的互相关联,该工作通过一个左乘操作确保统一实例∏的视觉和单词特征在A空间中一致:

其中,

因此能够通过最小化语义相关度的二范数得分,保证生成的单词与视频视觉上下文之间的语◥义一致性,使句子具有丰富的语义上下文信息。

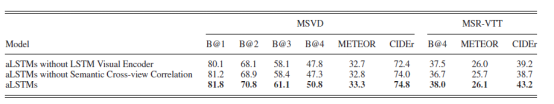

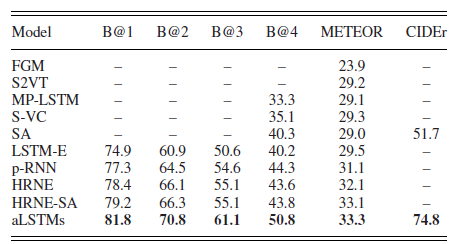

在实验验证阶段,工作组分别测试了长短时记忆视觉编码模块和语义一致性模块在模型当中的具体效果,实验结果如下表所示:

能够看出两者对于╲最终模型都有非常大的贡献,两者也是缺一不可。

作者将该工作模型结果和当时最好的一些方法的〓结果进行了比较,从MSVD数据集的实验结果来看,该工作模型在各项指标中都取得了当时最好的结果,这也验证了模型的有效性。

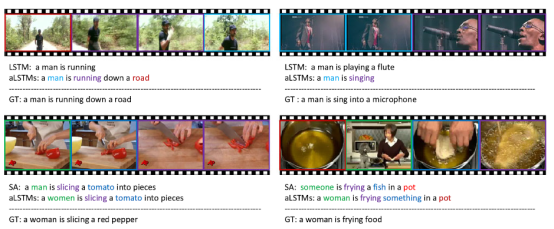

除ξ 了量化指标之外,论文作者还展示了一些模型生成句子卐的一些结果,图中SA表示的是soft attention方法,GT表示的是groundtruth,是人类针对这些视频数据进行的标注。从这个可视化图来看的话,首先表示了该工作增加的语义一致性思想是有效的,它能生成更加●准确的句子描述,能更加准确的把握视频当中的关键信息,例如“road”,“singing”等动作。和其他的方法相比的话它的预测也更加准确,更加接近人类的语言描述习惯。

相关链接:

高联丽研究员累计发表高水平国际论文100余篇(一作/通讯53篇),Google Scholar引用2289次。在国际顶级期刊▓和会议(如CCF A类会议、IEEE/ACM汇刊等)上发表论文共计50余篇,如IEEE T-PAMI、IJCV、 IEEE T-IP、 IEEE T-MM、CVPR、ACM Multimedia、AAAI/IJCAI等。其中入选ESI高被引论文4篇(一作/通信),并获得IEEE TMM最佳论文奖、国际会议ADC最佳学生论文奖。主持多项国家级和省部级项目,主研国家科Ψ 技部重点项目一项,自然科学基金面上项目一项等。曾担任CCF-B会议的ISWC研讨会的程序委员会主席,SCI期刊JCVIR特刊的客座编委,APWEB-WAIM会议研讨会(workshop)主席(chair)等学▅术兼职,以及担任CCF推荐的多个会议和期刊的审稿▓人。获2019年阿⊙里巴巴“达摩院青橙奖”(全国仅10名),2020年IEEE TCMC学术新星奖(Rising Star Award),入选2020年四川省“三八红旗手”。

未经允许不得转载:二九年华大学门户 » 高联丽研究员荣获IEEE Transaction on Multimedia最佳论文奖

相关推荐

- 王志明教授团队在【《Accounts of Chemical Research》发表封面论①文

- 太惠玲教授荣获“十佳四△川省五一巾帼标兵”荣誉称号

- 宜宾市委书记刘中伯○一行来校访问

- 电子薄膜与←集成器件国家重点实验室学术委员会召开年会

- 四川省第一封高考录取通知书从电子科大发出

- 出版︽社参加首届“天府书展”4场活动展示文化自●信

- 经管学院与电子科大〖出版社研讨出版合作

- 学工部举行辅导员工作室答辩会

- 第三届新四会能力挑战赛精彩上演

- 第四届电子科技大学“互联网+”本科教育高峰论坛开幕

- 爱尔兰驻¤华大使李修文一行来校访问

- 四川省委书记彭清华来校调研

- 电子科大与国网四川省电力公司共建泛在电力物联网联合研究院

- 如期开课首▆日,王亚非书记与师生一起在线上课

- 公共管理学院举办“万里星河,且梦且歌—请回答2020”迎新晚会

- 学校党■委理论学习中心组就“科技报国担使命,奋力建设‘双一流’”进行集中学习

- 电子科◣大邓旭教授团队在Nature发表封面论文

- 资环学院举行2019年“资意生长,青春飞扬”表彰大会暨迎新晚会

- 【抗击新冠肺炎】黄晓波:带病援鄂,奋力战“疫”!

- 【美丽成电·奉献之美】卜凡:让更多人快乐才更有意义

新闻公告

- 吴满意教授国家社科基金重大项目开题论证※会举行 07-27

- 学校与中行四川省分行研讨金融科技创新发展 07-26

- 电子科大举行2020年招生政策发布会暨咨询会 07-24

- 电子科技大学肿瘤医工研究院授牌 07-23

- 从同一所高中“组团”到电子科大,他们将优秀延续 07-23

- 马周辰:直博名校、收获爱情,用汗水浇灌灿烂花朵 07-22

高考招生

- 电子科技大学2018全日制普通本科招生章程 08-05

- 电子科技大学2016全日制普通本科招生章程 08-05

- 电子科技大学2017全日制普通本科招生章程 08-05

- 电子科技大学2014年全日制普通本科』招生章程 08-05

- 电子科技大学2015年全日㊣制普通本科招生章程 08-05

- 格拉斯哥学院2015招生简章 08-05

- 电子科技大学2013年全日制普通本科招生章程 08-05

- 电子科技大学2011年全日制普通本科招生章程 08-05

- 电子科技大学2012年全日制普通本科招生章程 08-05

- 电子科技大学2008年招生章程 08-05